一、Spark是基于RDD的计算

注意:Spark并没有读文件的方法,借用的是MR读文件的方法。

MR读文件特点:首先他会将文件切片,划分为一个个split

block(个数)=split=partition

二、RDD是分布式弹性数据集,哪些特性体现了分布式:

1、多个partition组成弹性

2、依赖关系

3、容错

Spark运行流程

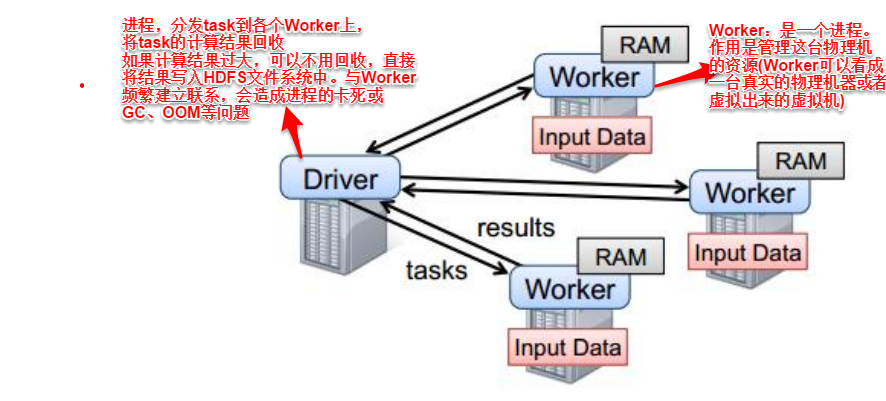

四、worker:真正计算的节点

driver:不会执行业务逻辑

解释:

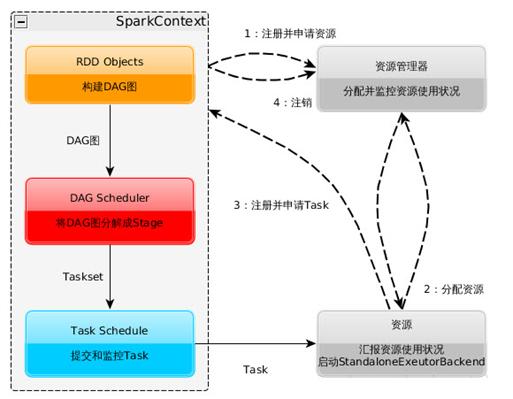

1.构建Spark Application的运行环境(启动Spark Context),Spark Context向资源管理器(可以是Standalone、Mesos、Yarn)注册并申请Executor资源;

2.资源管理器分配Executor资源并开启StandaloneExecutorBackend,Executor运行情况将随着心脏发送到资源管理器上;

3.SparkContext构建DAG图,将DAG图分解成stage,并把Taskset发放给Task Scheduler,Executor向Spark Context申请Task,Task Sheduler将task发放给Executor运行同时Spark Context将应运程序代码发放给Executor

4.Task在Executor上运行,运行完毕释放所有资源

点击查看更多内容

1人点赞

评论

共同学习,写下你的评论

评论加载中...

作者其他优质文章

正在加载中

感谢您的支持,我会继续努力的~

扫码打赏,你说多少就多少

赞赏金额会直接到老师账户

支付方式

打开微信扫一扫,即可进行扫码打赏哦