1.下载Hadoop

Hadoop的版本:Hadoop-2.6.0-cdh5.7.0

下载地址:http://archive.cloudera.com/cdh5/cdh/5/hadoop-2.6.0-cdh5.7.0.tar.gz

目录列表:http://archive.cloudera.com/cdh5/cdh/5/

文件存放路径(非必须,可自定义)

创建一个hadoop用户

/home/hadoop

software: 存放的是安装的软件包

app: 所有软件的安装目录

data: 所有使用的测试数据

source: 存放的是软件源码,比如spark这种需要编译的软件,源码就放在这里。

2.平台选择

Linux和Windows都支持,但是官方建议使用Linux,最多能够支持2000个nodes。

3.Java和SSH安装

jdk:

使用JDK 7u51版本

下载地址: http://download.oracle.com/otn/java/jdk/7u51-b13/jdk-7u51-linux-x64.tar.gz

列表地址: http://www.oracle.com/technetwork/java/javase/downloads/java-archive-downloads-javase7-521261.html

解压到app目录:

tar -zxvf jdk-7u51-linux-x64.tar.gz -C ~/app/

tar -zxvf jdk-7u51-linux-x64.tar.gz -C ~/hadoop/app/

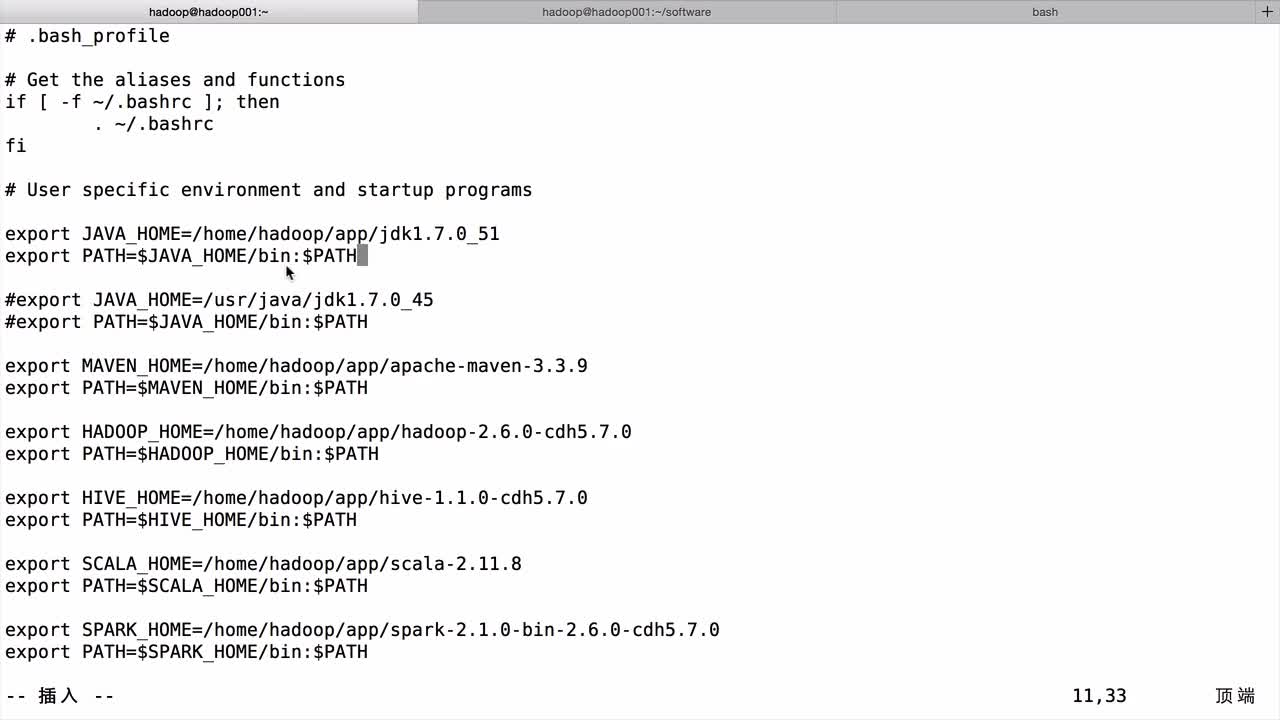

配置环境变量:

vim ~/.bash_profile

SSH:

sudo apt-get update

sudo apt-get install ssh

sudo apt-get install pdsh

4.Linux机器的常用参数设置

修改hostname:

vi /etc/sysconfig/network

Ubuntu是:

/etc/network/interfaces

NETWORKING=yes

HOSTNAME=hadoop001

修改IP和映射关系:

vi /etc/hosts

本机IP hadoop001

127.0.0.1 localhost

5.ssh免密码登录(本步骤可以省略,但是每次重启Hadoop都需要手动输入密码)

生成密钥

ssh-keygen -t rsa

cp ~/.ssh/id_rsa.pub ~/.authorized_keys

6.配置Hadoop

解压Hadoop文件到app目录

Hadoop配置文件修改:

app目录下的Hadoop文件夹,下面的etc/hadoop里。

hadoop-env.sh:

配置Java_Home 的路径

export JAVA_HOME=/home/hadoop/app/jdk1.7.0_51

core-site.xml:

修改默认文件系统的名称

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:8020</value>

这里也可以使用hdfs://hadoop001:8020

</property>配置tmp文件目录

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/tmp</value>

</property>

</configuration>在1.0版本一般使用的端口是9000

hdfs-site.xml

修改文件系统副本系数,默认为3,但是我们只有一台机器,所以修改为1。

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>7.格式化HDFS

这个操作只在安装的时候,第一次执行。

hadoop安装的bin目录下执行:

./hdfs namenode -format

看到如下内容代表成功

17/06/18 00:06:10 INFO namenode.FSImage: Allocated new BlockPoolId: BP-1202859485-192.168.234.128-1497715569921

17/06/18 00:06:10 INFO common.Storage: Storage directory /home/cheshen/hadoop/app/tmp/dfs/name has been successfully formatted.

17/06/18 00:06:10 INFO namenode.NNStorageRetentionManager: Going to retain 1 images with txid >= 0

17/06/18 00:06:10 INFO util.ExitUtil: Exiting with status 0

17/06/18 00:06:10 INFO namenode.NameNode: SHUTDOWN_MSG:

/****

SHUTDOWN_MSG: Shutting down NameNode at hadoop001/192.168.234.128

****/

8.启动HDFS

sbin/start-dfs.sh

如果报错JAVA_HOME找不到,需要去hadoop安装目录下的/etc/hadoop/hadoop-env.sh,修改JAVA_HOME的值。

启动以后,使用jps验证是否启动成功。

2811 SecondaryNameNode

2594 DataNode

2921 Jps

2470 NameNode

或者直接访问:

http://192.168.234.128:50070

hadoop001:50070

9.停止HDFS

sbin/stop-dfs.sh

Hadoop目录说明:

bin: 主要存放的是,客户端的一些脚本

etc: 配置文件相关的

sbin: 服务器相关的

start-all.sh: 启动整个集群

start-dfs.sh: 启动HDFS

start-yarn.sh: 启动yarn

cmd 是windows下的

etc/hadoop/slaves 配置的是从节点

共同学习,写下你的评论

评论加载中...

作者其他优质文章