True Positive:真阳性(把阳性的判6为阳性)TP

False Negatives :假阴性(把阳性判为阴性)FN

False Positive :假阳性(把阴性的判为阳性)FP

True Negatives:真阴性(把阴性的判为阴性)TN

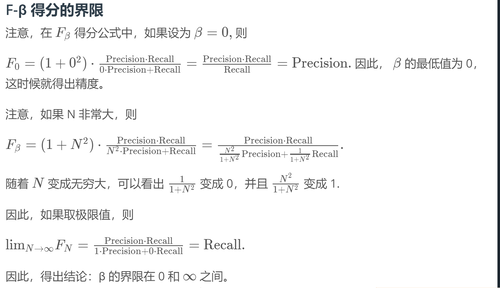

例子: 类型1和类型2错误有时在一些文档中,你会看到把假阳性和假阴性称为类型1和类型2错误。 这是定义: 类型1错误(第一类错误或假阳性): 在医学诊断例子中,这是我们误诊一个健康人为病人 类型2错误(第二类错误或假阴性):在医学诊断例子中,这是我们漏诊一个病人为健康人 准确率 Accuracy = (TP+TF)/(TP+TF+FP+FN)准确率 = (真阳性+真阴性)/(真阳性+真阴性+假阳性+假阴性) from sklearn.metrics import accuracy_score 然而 ,准确率不是永远都好用,因为当数据偏斜分布时,它可能会完全错过一些点。 精度(P) (查准率)Precision = TP/(TP+FP) 精度 = 真阳性/(真阳性+假阳性) (P:找出有多少是真正地患者) 召回率(Recall) Recall = TP/(TP+FN)召回率 = 真阳性/(真阳性+假阴性)在医疗上相当重要! (R:与精度相反,找出有多少假阴性患者) F1得分 F1 score F1 score = 2 *(Precision∗Recall/Precision+Recall) 如果两个数相等,那么这两个数的平均值总是在x和y之间取值。 调和平均值总是小于算术平均值. 例如,如果精度为1,召回率为0,平均值就是0.5.这个调和的平均值就为0 . 另外一个例子,如果 精度为 0.2,召回率为0.8 。算术平均值就是为0.5 。这个调和的平均值就是为0.32 。 对于F1分数来说。如果两个数的指标,有一个比较小,就会取较小那个。 F -BETA 得分 (F-β) (比较方便我们调整,如我们更加关注精度,或者更加关注召回率) β调小,更偏向精度,调大更偏向召回率 。

点击查看更多内容

1人点赞

评论

共同学习,写下你的评论

评论加载中...

作者其他优质文章

正在加载中

感谢您的支持,我会继续努力的~

扫码打赏,你说多少就多少

赞赏金额会直接到老师账户

支付方式

打开微信扫一扫,即可进行扫码打赏哦