-

1.线性模型和卷积模型都已经训练完成,现在需要暴露接口供前端界面调用。

2.如何编写接口呢?写在main.py:

import numpy as np

import tensorflow as tf

from flask import Flask, jsonify, render_template, request

from mnist import model

x = tf.placeholder('float', [None, 784]) # 声明输入

sess = tf.Session() # 定义一个Session

# 拿线性回归模型,ckpt

with tf.variable_scope('regression'):

y1, variables = model.regression(x)

saver = tf.train.Saver(variables)

saver.restore(sess, 'mnist/data/regression.ckpt') # 通过restore方法把模型文件拿出来

# 拿卷积模型和线性同样的方法

with tf.variable_scope('convolutional'):

keep_prob = tf.placeholder('float')

y2, variables = model.convolutional(x, keep_prob)

saver = tf.train.Saver(variables)

saver.restore(sess, 'mnist/data/convolutional.ckpt')

def regression(input):

return sess.run(y1, feed_dict={x: input}).flatten().tolist() # 转换成list

def convolutional(input):

return sess.run(y2, feed_dict={x: input, keep_prob: 1.0}).flatten().tolist()

# 以上步骤之后,两个模型的输入以及如何把数据喂进来以及如何跑这个模型已经完成

# 做接口,用Flask

app = Flask(__name__)

@app.route('/api/mnist', methods=['post']) # 定义一个注解,路由,表示前端传进来之后应该用哪个接口

def mnist():

input = ((255 - np.array(request.json, dtype=uint8)) / 255.0).reshape(1, 784) # 做一个数组的换算,我们模型定义的形状就是1*784的形状

output1 = regression(input)

output2 = convolutional(input)

return jsonify(results=[output1, output2]) # 把结果封装一下

# 定义一个方法来启动它

if __name__ == '__main__':

app.debug = True

app.run(host='0.0.0.0', port=8000)

查看全部 -

1.在GPU上运行可能会稍微快一些比在CPU上。

2. for i in range(20000): # 对于这样的卷积训练一般要做10000-20000次的循环

batch = data.train.next_batch(50) # 定义batch的大小

if i % 100 == 0: # 每隔100次准确率做一次打印

train_accuracy = accuracy.eval(feed_dict={x: batch[0], y_: batch[1], keep_prob: 1.0})

print('step %d, training accuracy %g' % (i, train_accuracy)) # 打印

sess.run(train_step, feed_dict={x: batch[0], y_: batch[1], keep_prob: 0.5})

print(sess.run(accuracy, feed_dict={x: data.test.images, y_: data.test.labels, keep_prob: 1.0}))

# 保存

path = saver.save(

sess, os.path.join(os.path.dirname(__file__), 'data', 'convolutional.ckpt'),

write_meta_graph=False, write_state=False

)

print('Saved:', path)

查看全部 -

1.定义完卷积的模型之后,定义卷积的文件:model->convolutional

import os

from mnist import model

import tensorflow as tf

from mnist import input_data

data = input_data.read_data_sets('MNIST_data', one_hot=True)

# model

with tf.variable_scope('convolutional'):

x = tf.placeholder(tf.float32, [None, 784], name='x')

keep_prob = tf.placeholder(tf.float32)

y, variables = model.convolutional(x, keep_prob)

# train

y_ = tf.placeholder(tf.float32, [None, 10], name='y')

cross_entropy = -tf.reduce_sum(y_ * tf.log(y))

train_step = -tf.train.AdamOptimizer(1e-4).minimize(cross_entropy) # 随机梯度下降的方式

correct_prediction = tf.equal(tf.argmax(y, 1), tf.argmax(y_, 1)) # 判断参数是否相等

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

saver = tf.train.Saver(variables)

with tf.Session() as sess:

merged_summary_op = tf.summary.merge_all() # 合并参数,操作符

summary_writer = tf.summary.FileWriter('/tmp/mnist_log/1', sess.graph) # 将参数的路径、输入输出图放到哪里

summary_writer.add_graph(sess.graph) # 把图加进来

sess.run(tf.global_variables_initializer())

查看全部 -

1.# 第二层实际上和第一层是一样的

W_conv2 = weight_variable([5, 5, 32, 64]) # 权重

b_conv2 = bias_variable([64]) # 偏置项

h_conv2 = tf.nn.relu(conv2d(h_pool1, W_conv2) + b_conv2) # 定义卷积

h_pool2 = max_pool_2x2(h_conv2) # 定义池化

# full connection

W_fc1 = weight_variable([7 * 7 * 64, 1024])

b_fc1 = bias_variable([1024])

h_pool2_flat = tf.reshape(h_pool2, [-1, 7*7*64]) # 全连接层的池化

h_fc1 = tf.nn.relu(tf.matmul(h_pool2_flat, W_fc1) + b_fc1)

h_fc1_drop = tf.nn.dropout(h_fc1, keep_prob) # dropout 可以扔掉一些值,防止过拟合

W_fc2 = weight_variable([1024, 10])

b_fc2 = bias_variable([10])

y = tf.nn.softmax(tf.matmul(h_fc1_drop, W_fc2) + b_fc2)

return y, [W_conv1, b_conv1, W_conv2, b_conv2, W_fc1, b_fc1, W_fc2, b_fc2]

查看全部 -

1.训练卷积模型和线性模型的基本步骤都是一样的:第一步是定义模型;定义模型之后使用模型,使用模型之后定义一个训练,一次次迭代之后把模型文件ckpt保存下来,以供后续来使用。

2.定义模型:

# 卷积模型:多层卷积

def convolutional(x, keep_prob):

def conv2d(x, W): # 定义一个2*2的卷积

return tf.nn.conv2d([1, 1, 1, 1], padding='SAME')

def max_pool_2x2(x): # 定义一个2*2的池化层

return tf.nn.max_pool(x, ksize=[1, 2, 2, 1], strides=[1, 2, 2, 1], padding='SAME')

def weight_variable(shape): # 定义一个权重变量

initial = tf.truncated_normal(shape, stddev=0.1)

return tf.Variable(initial)

def bias_variable(shape): # 定义一个偏置项变量

initial = tf.constant(0.1, shape=shape)

return tf.Variable(initial)

# 定义卷积层,第一层:

x_image = tf.reshape(x, [-1, 28, 28, 1]) # 定义图像

W_conv1 = weight_variable([5, 5, 1, 32]) # 权重

b_conv1 = bias_variable([32]) # 偏置项

h_conv1 = tf.nn.relu(conv2d(x_image, W_conv1) + b_conv1) # 定义卷积

h_pool1 = max_pool_2x2(h_conv1) # 定义池化

# 第二层实际上和第一层是一样的

查看全部 -

1.开始训练,训练完之后进行保存:

# 参数进行保存

saver = tf.train.Saver(variables)

# 开始训练

with tf.Session() as sess:

sess.run(tf.global_variables_initializer()) # 把全部的参数放进来,进行全局初始化

for _ in range(1000): # 训练1000次

batch_xs, batch_ys = data.train.next_batch(100)

sess.run(train_step, feed_dict={x: batch_xs, y_: batch_ys}) # feed_dict:喂参数,x放的batch_xs,y_放的batch_ys

print((sess.run(accuracy, feed_dict={x: data.test.images, y_: data.test.labels}))) # 打印测试集的图像和标签

path = saver.save(

# 把数据存进去,把这个模型的名字存成regression.ckpt,在这里注意data文件夹的创建

sess, os.path.join(os.path.dirname(__file__), 'data', 'regression.ckpt'),

write_meta_graph=False, write_state=False # 写到图中

) # 把数据或者说是参数或者说是模型存起来

print('Saved:', path) # 把保存模型的路径打印出来

查看全部 -

1.线性模型:

# Y = W * x + b

def regression(x):

W = tf.Variable(tf.zeros([784, 10], name='W')) # 784 * 10的二维数组

b = tf.Variable(tf.zeros([10]), name='b') # 一维数组里面放10个值

y = tf.nn.softmax(tf.matmul(x, W) + b) # softmax做简单的线性运算

return y, [W, b]

2. 定义完模型之后引入模型和训练:

# create model

with tf.variable_scope('regression'): # 命名

x = tf.placeholder(tf.float32, [None, 784]) # x:待用户输入,用一个占位符,placeholder的第一个参数是类型,第二个是张量,其中的784是和model中对应

y, variables = model.regression(x)

# train

y_ = tf.placeholder('float', [None, 10])

cross_entropy = -tf.reduce_sum(y_ * tf.log(y)) # 训练的交叉熵

train_step = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy) # 训练步骤,GradientDescentOptimizer(0.01):一个优化器,设置步长为0.01

correct_prediction = tf.equal(tf.argmax(y, 1), tf.argmax(y_, 1)) # 预测

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32)) # 准确率,tf.cast(correct_prediction, tf.float32):转换格式

查看全部 -

1.项目要达成的效果:

2.python环境:anaconda,是python语言最常用的环境之一,包含大量的科学包及其依赖。

IDE:Pycharm

1. mnist训练分为两个部分:mnist训练的部分和前端界面的部分。

2. 在python中或者TensorFlow中,下载mnist数据集有两种方式:第一种从网上下载导到工作目录中,第二种是通过代码编写下载mnist数据集。下载的MNIST数据集有四个文件,分为两部分,测试集和训练集,然后每一部分都分为image和label,一一对应。

下载MNIST数据集:

input_data.py(这部分代码可以在官网中找到)——》regression.py中调用导入数据集(read_data_sets())

查看全部 -

1.Flask框架是一个轻量级的web应用框架。所谓的轻量级说的是无需编写太多编码便可以实现很多功能。应用框架是指可以把这个框架做成一个个接口、后台、应用。Flask框架使用Python语言进行编写。

2.训练MNIST数据集的训练步骤:

1)下载数据集2)编写训练程序3)训练模型4)验证训练的模型(准确率等)

3.使用Flask调用模型的调用步骤:

1)使用训练好的模型

2)定义参数

3)通过端进行传参(不单单是指web前端,还有比如说手绘板等都是一个端)

4)进行数据验证并返回

4.整合步骤:

1)训练并生成模型

2)暴露接口,传递接口的方法有两种:用谷歌自带的grpc接口或者用web框架

3)前端调用

4)验证并返回结果

查看全部 -

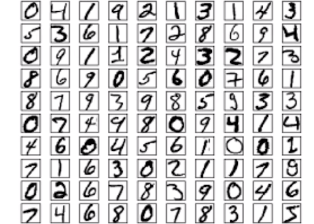

1.MNIST数据集是由Google和纽约大学克朗研究所共同建立的手写数字的数据库。共有70000张训练图像(包括60000张训练图像和10000张测试图像)。所有图像均是0-9的手写数字。

我们在做深度学习模型时,一般需要有两种数据集,一种是训练数据集,用于生成模型,一种是测试

数据集,用于验证。

2.MNIST数据集展现形式:

由上可知,我们以后在选择数据集的时候应该让数据具有唯一性。

查看全部 -

1.TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统(DistBelief是谷歌的第一代人工智能系统)。Alpha-go用的就是TensorFlow框架。可被用于语音识别或图像识别等多项机器学习和深度学习领域。TensorFlow是将复杂的数据结构传输至人工智能神经网中进行分析和处理过程的系统。TensorFlow支持CNN、RNN和LSTM算法,这都是目前在Image、Speech和NLP最流行的深度神经网络模型。CNN一般用于图像识别,RNN一般用于文本处理,LSTM是RNN的一种变体。

查看全部 -

1. 自从2016年谷歌的alpha-go战胜了世界围棋冠军之后,机器学习和人工智能领域就变得异常火爆。从最早的苹果的Siri到智能垃圾邮件处理,再到微软的一些语音,还有谷歌的在线翻译都是人工智能、深度学习在后台起到至关重要的作用。人工智能在生活中无处不在。比如手机的语音识别,微信里说一句话可以翻译成很多字。现在人工智能取代了一些人力劳动,比如扫地机器人。

2. 课程背景:人工智能和深度学习相关领域的崛起

人工智能的实际应用需求

人工智能与现有技术的结合

查看全部 -

https://github.com/GeoLibra/mnist_test.git

查看全部 -

tf框架介绍

查看全部 -

使用Flask调用模型步骤:

使用训练好的模型

定义参数

通过端进行传参

进行数据验证并返回

查看全部

举报