作者:闲鱼技术——齐悟

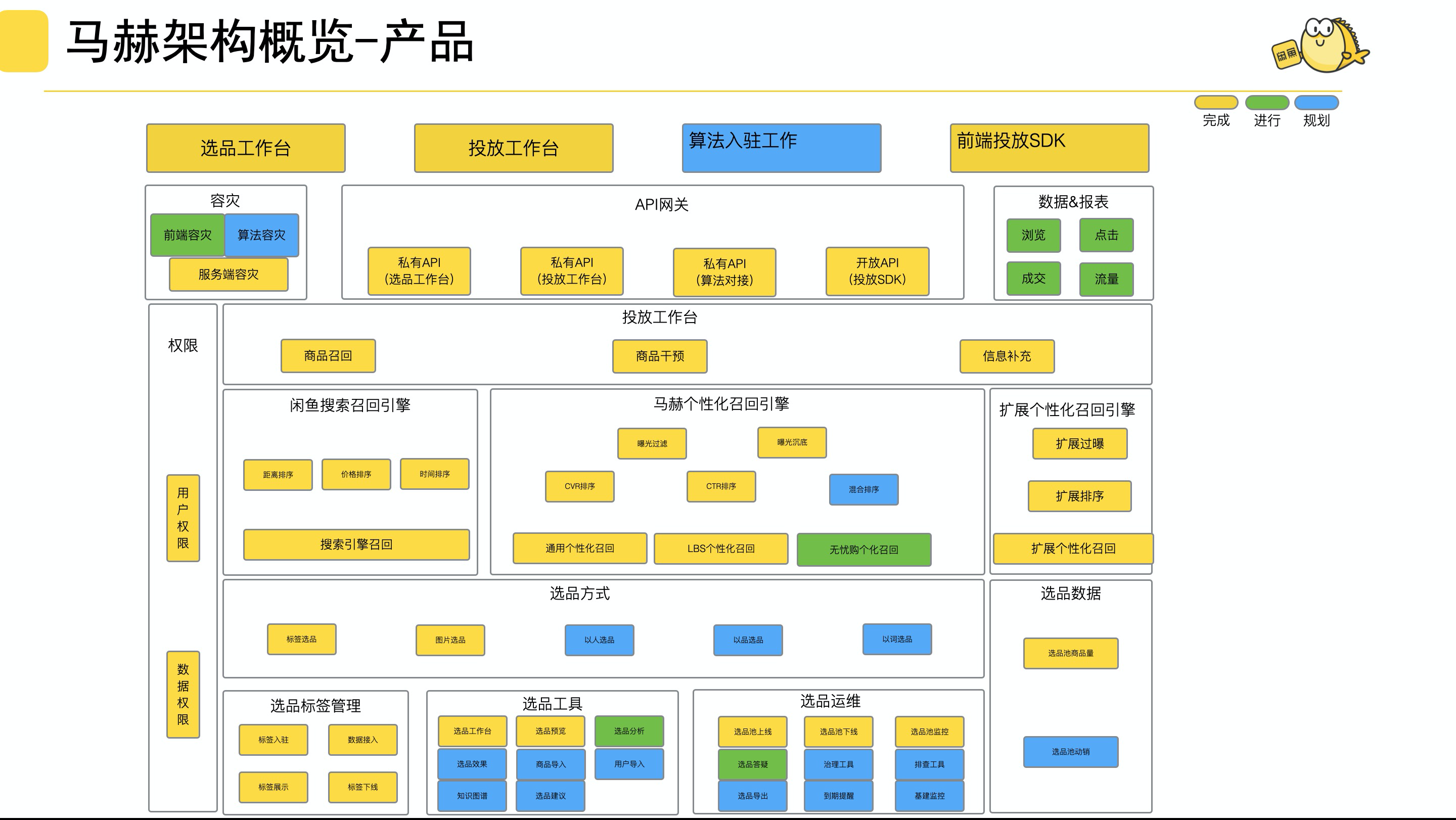

马赫是闲鱼的选品和投放系统,闲鱼业务中多数商品都是孤品即单库存商品,所以商品的实时变更需要即刻反馈到选品和投放链路中,为了满足业务诉求马赫设计之初就把实时性作为最重要的技术目标,随着系统的运行数据的膨胀实时性也遇到了瓶颈,本文将介绍近一年来在提升马赫实时性上的相关工作,目标是选品实时性延迟控制在秒级别。如果有对马赫不了解的同学可以回顾公众号内马赫相关文章。

选投实时链路

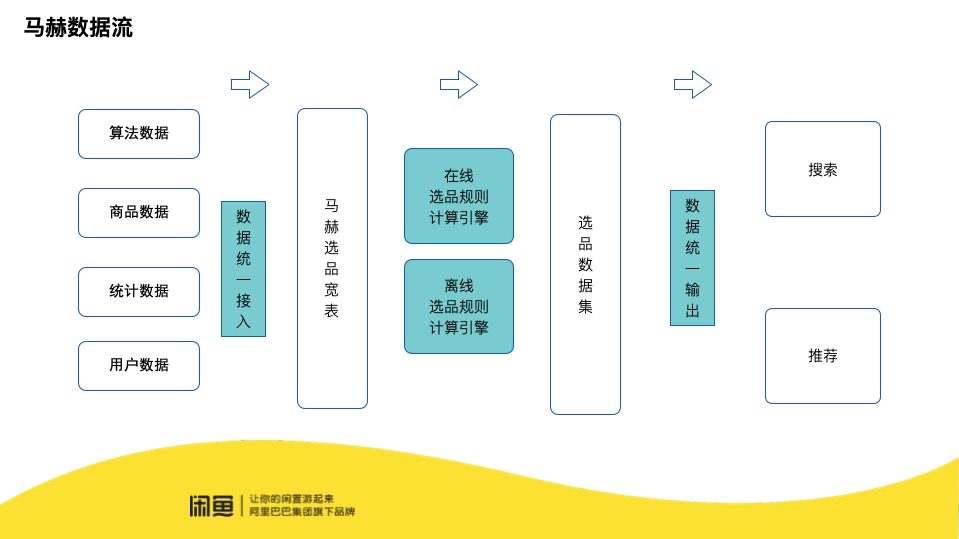

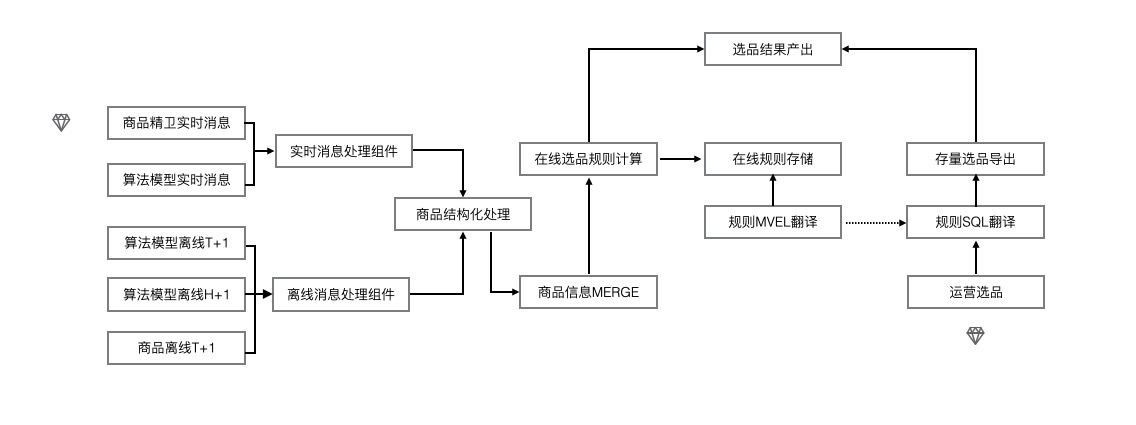

马赫整个选品和投放的过程中数据流转如下图所示主要分为三个部分,第一部分是选品数据接入,数据是马赫选品的根本,数据的实时是整个马赫流程能有效运转的基础。第二部分是选品规则计算,规则计算是马赫的核心,计算的实时性保证了马赫能把选品结果同步到各个下游节点。第三部分是商品投放,商品投放是与用户距离最近的部分,实时的反馈能给用户带来更好的体验。

选品数据实时性能优化

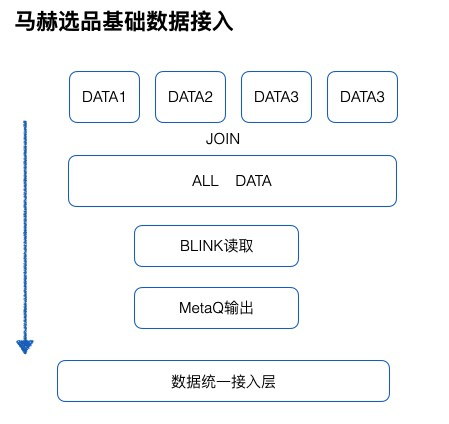

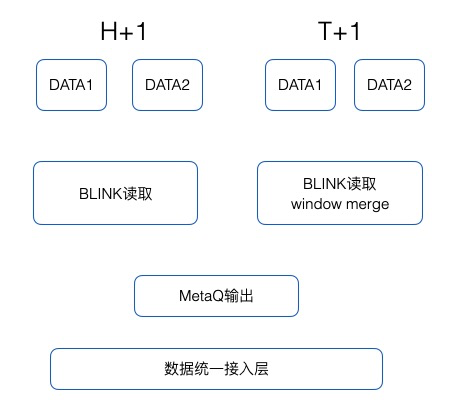

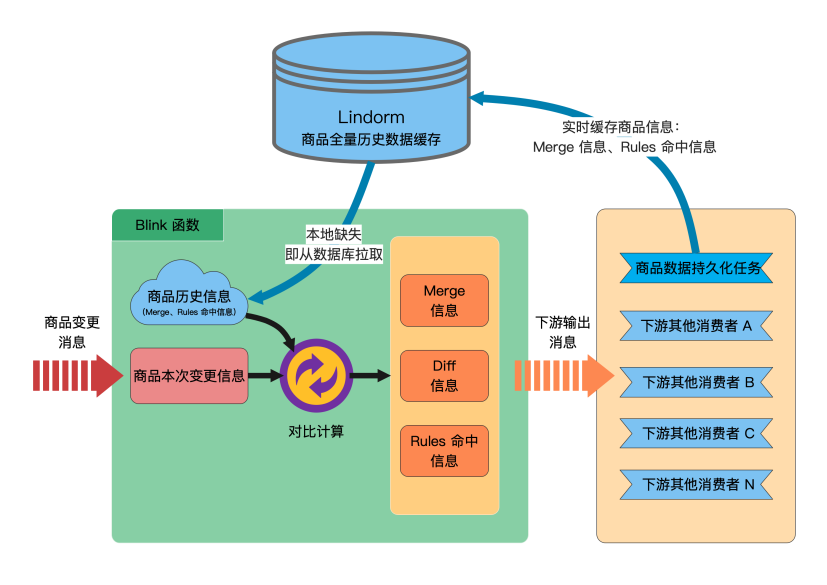

马赫选品依赖的选品宽表数据,主要由两类数据构成,一类是商品基础数据,商品基础数据指用户发布的商品信息包括:商品类型、商品状态、商品价格、商品描述、商品图片;该类数据通过订阅商品数据库的变更已经实现了实时性。另外一类是基于商品衍生出的统计和预测数据,这类的数据一般都是通过ODPS(阿里内部离线计算平台)离线计算,产出时间与商品基础相比大多是天级别或小时级别延迟,该类数据原有的接入方案如下,无论是小时级别延迟还是天级别延迟产出的数据,都是进行统一的处理,每天把所有的数据JOIN到一起后输出到一个离线数据表中,然后把该数据通过BLINK 和 MetaQ消息通道与马赫的数据统一接入层对接。该方案的优点是所有的离线产出数据只需要处理一次方便运维,同时每天一次回流整个过程的数据量可控。缺点也是显而易见,首先每天汇总数据产出时间取决于上游耗时最长的数据,如果有数据延迟将会影响整个流程的耗时,其次明明是H+1产出的数据却要等到T+1才可使用,这严重影响了选品能力。

选品规则计算实时性优化

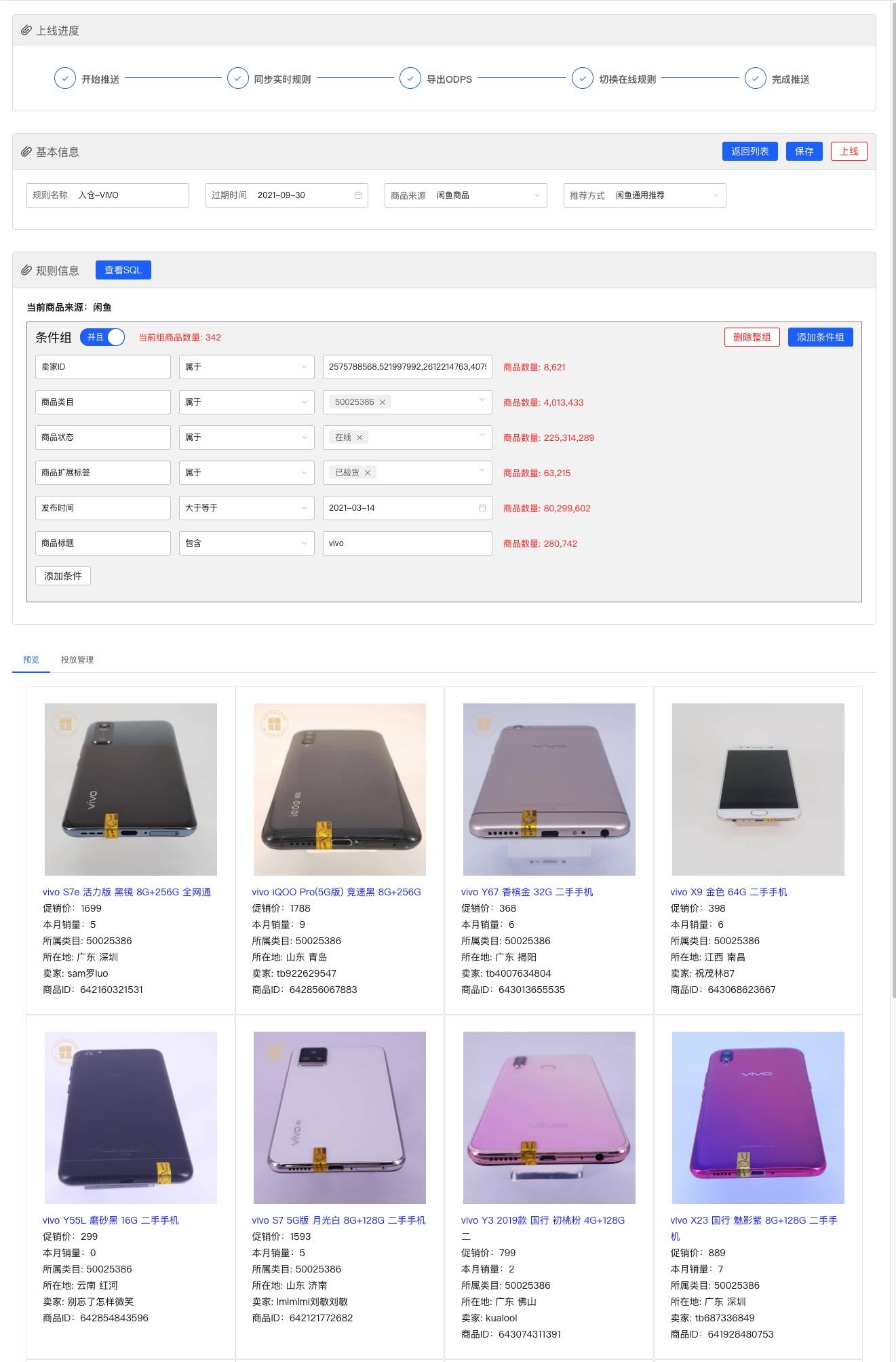

选品规则计算包含两个部分一部分是运营创建选品规则时在马赫选品宽表中运算选并产出结果集称为离线选品规则执行引擎,另一部分是当商品信息变更时需要重新计算当前商品命中的选品规则称为在线选品规则执行引擎。 首先介绍第一部分离线选品规则执行引擎的优化,运营创建的选品规则会映射成SQL在马赫选品宽表ADB上进行执行,ADB是全索引数据表这里主要是用空间去换时间,但是有一类问题很难解决就是文本的全字段匹配,举一个例子选品宽表中有个从商品基本数据表中映射字段ATTRIBUTE,从名字就不难看出该字段是当时商品设计中预留出的扩展字段,其内容以kv对分号分隔的形式进行存储,运营在进行选品时最终映射到该字段的规则SQL是用LIKE关键字进行在十几亿的数据中检索在其性能可想而知。所以针对该类字段做了多值映射即把kv对映射成数字进行存储,该方案虽然不复杂但是解决了创建规则时商品量计算以及商品预览的时效性问题不做过多赘述,优化后商品计算从6分钟级别降至30秒,具体效果如下:

商品投放的实时优化

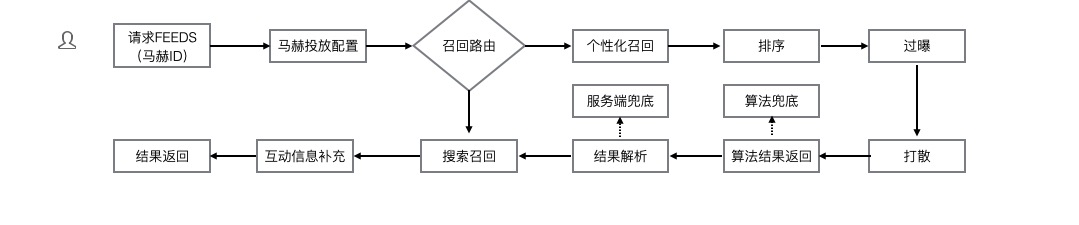

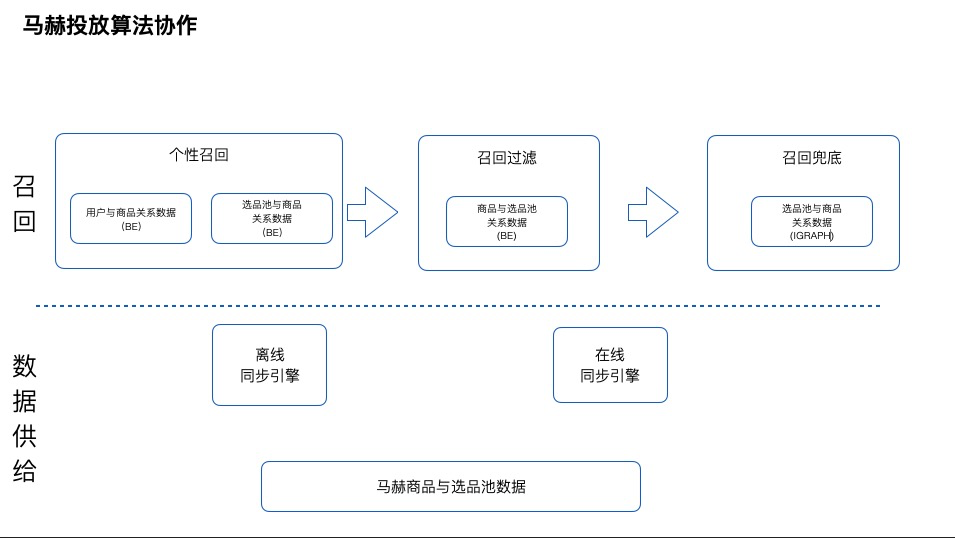

商品投放是与用户侧距离最近的能力,运营圈选商品后形成商品池,然后利用商品池搭建页面投放给用户,在用户请求时把商品从商品池中召回然后展现给用户,具体流程如下图所示。

总结

本文从马赫选品到马赫投放实时性优化做了全面的介绍,每一步优化呈现的都是最终方案,为了保证系统的平滑过渡优化中中踩了很多坑不过最终都平稳落地,优化后的马赫从选品到投放整个实时链路时延有一个质的变化,选品数据从T+1变为H+1,选品流程从6分钟变为30秒,投放流程从2分钟变为2秒,系统更健壮也更实时,从整体功能看马赫还是属于一个工具级别系统,还远没有达到产品级别系统级。

作者:闲鱼技术

链接:https://juejin.cn/post/6954972167519862797

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

共同学习,写下你的评论

评论加载中...

作者其他优质文章