🚀接上篇我们深度解析了《FastGPT与DeepSeek-R1的本地模型对接之路》,今天我们分享私有化向量模型BGE-M3+ FastGPT无缝接入技巧!还是熟悉的配方,但这次我们将直捣技术核心!**

直捣黄龙BGE-M3模型注入

🔥浏览器输入:http://ip:3000

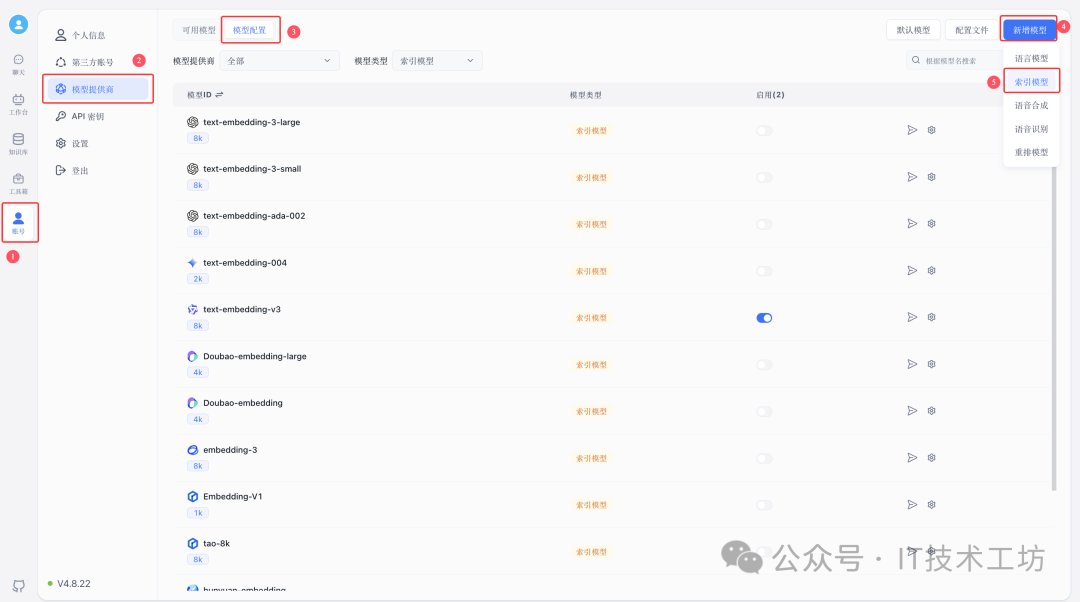

🔥左侧边栏最底部点击[账号]→[模型提供商],点击右上角[模型配置]选项卡。

核弹级参数配置

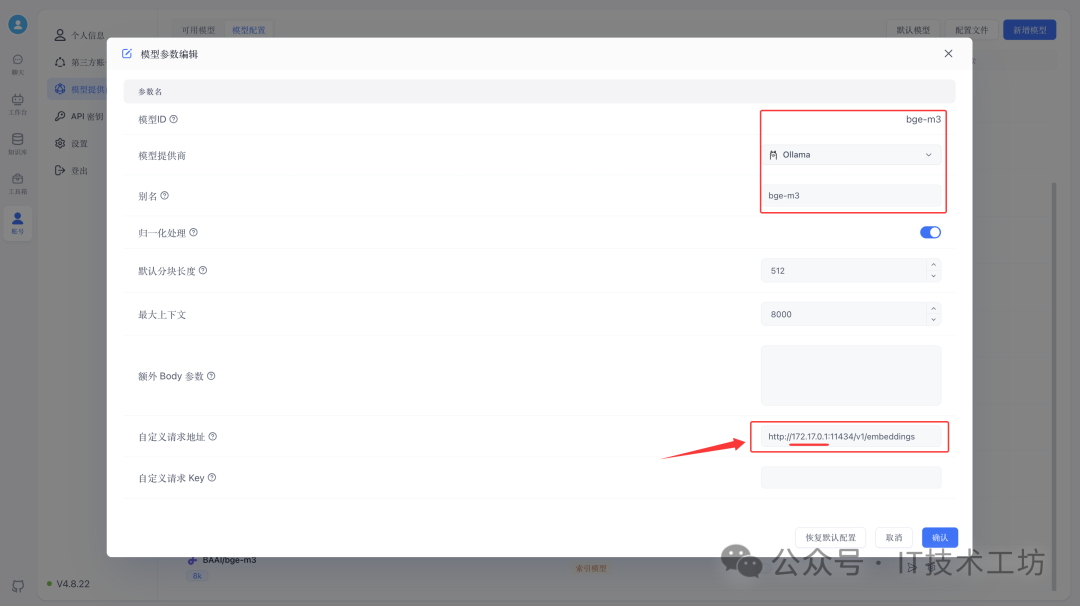

🔥点击[新增模型]→选择[索引模型],核心参数三连击。

⚠️在Docker多容器架构中,localhost指向的是当前容器的回环地址,而非宿主机!✅[自定义请求地址]正确姿势!

http://172.17.0.1:11434/v1/embeddings

🔥当FastGPT容器调用Ollama服务时,若配置为localhost:11434,FastGPT容器实际上在请求自身,必然引发Connection error💡

深入原理(参考上篇《从崩溃到成功:深度解析FastGPT与DeepSeek-R1的本地模型对接之路》)。**

终极链路验证

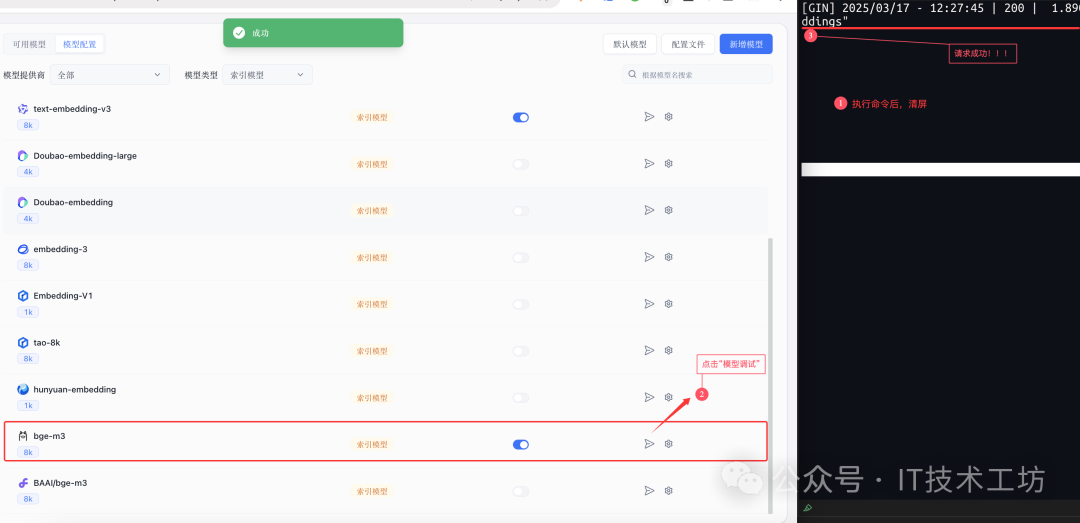

🔥开启Ollama上帝视角(新开终端执行命令,右键清屏)

docker logs -f ollama --tail 50

🔥双保险验证法,点击[模型测试]→ 出现绿色✅弹窗→ 日志捕获 POST "/v1/embeddings"|200✅

关注【IT技术工坊】下篇剧透 FastGPT+Ollama+deepseek R1:全民AI助手落地实战教程。

点击查看更多内容

为 TA 点赞

评论

共同学习,写下你的评论

评论加载中...

作者其他优质文章

正在加载中

感谢您的支持,我会继续努力的~

扫码打赏,你说多少就多少

赞赏金额会直接到老师账户

支付方式

打开微信扫一扫,即可进行扫码打赏哦