-

Hdfs的特点:

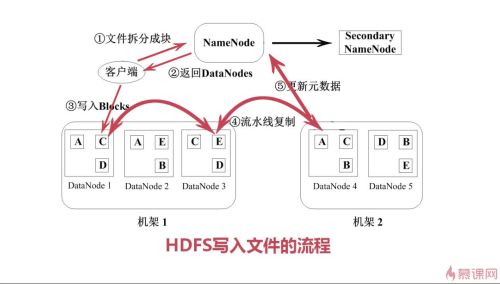

数据冗余,硬件容错(3个备份)

流式的数据访问(一次写入,多次读取,无法删改,只能通过写入到新的块删除旧文件)

存储大文件 (否则namenode消耗高,头大身小)

实用性和局限性:

适合数据批量读写,吞吐量高

不适合交互式应用,低延迟很难满足

适合一次写入多次读取,顺序读写

不支持多用户并发写相同文件

查看全部 -

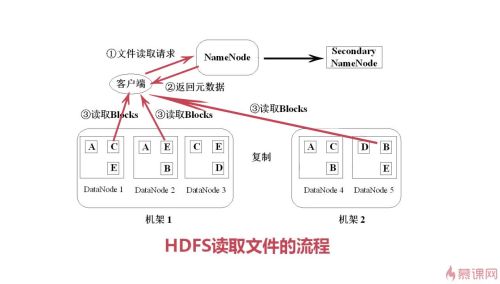

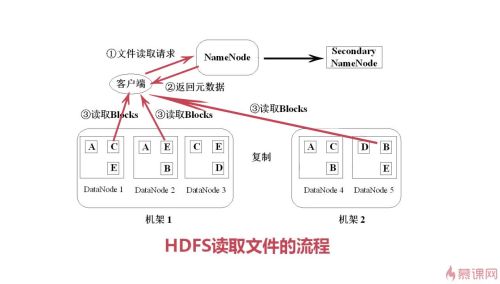

Hdfs文件读取流程:

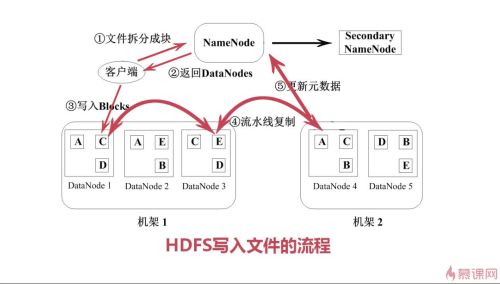

Hdfs文件写入流程:

查看全部

查看全部 -

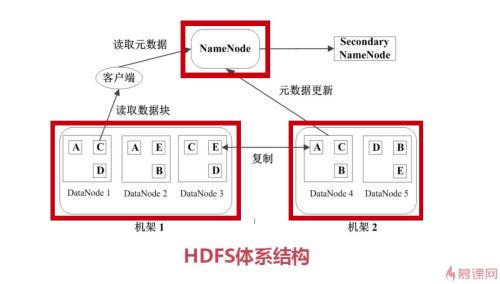

Hdfes数据管理:

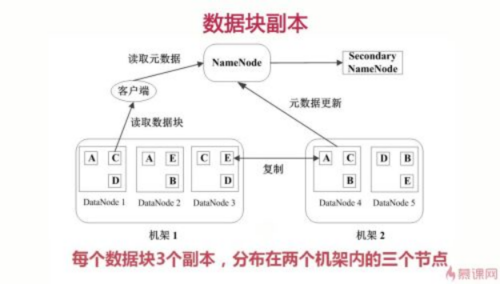

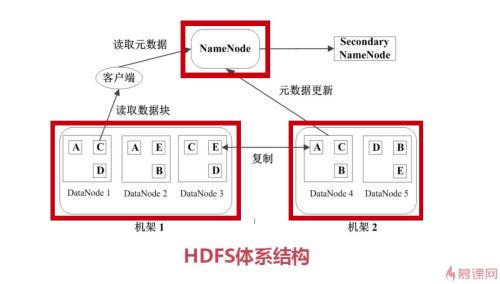

数据块副本:每个数据块3个副本,分布在2机架3节点上(容错性)

2. 心跳检测:DataNode定期向NameNode发心跳消息,刷新存在感!!

3. 二级NameNode:NameNdoe定期同步元数据映像文件到二级NameNode(secondryNameNode),一旦故障,备胎转正,成正宫娘娘!

查看全部

查看全部 -

HDFS的文件被分成块进行存储,HDFS块默认大小是64MB,快是整个文件存储处理的逻辑单元

HDFS中有两类节点NameNode和DataNode

namenode是管理节点,存放文件元数据,元数据包含两个部分

文件与数据快的映射表

数据块与数据节点的映射表

namenode是唯一的管理节点,里面存放大量元数据,客户进行访问请求,首先会到namenode查看元数据,这个文件放在哪些节点上面然后从这些节点拿数据块,然后组装成想要的文件

DateNode是HDFS的工作节点,存放数据块

查看全部 -

3

查看全部 -

需要配置Hadoop的环境变量

查看全部 -

hdfs:

高成本

低成本

成熟生态圈

hive

查看全部 -

Hadoop

查看全部 -

大数据 是个好东西

查看全部

举报