-

scrapy startproject douban

到spiders目录下生成

scrapy genspider douban_spider movie.douban.com

查看全部 -

Scrapy框架:

Scrapy Engine: Scrapy引擎,负责Spiders,ItemPipline,Scheduler,Downloader中间的通信信号和数据的传递,相当于是一个交通站。

Scheduler: Scrapy的调度器,就是一个队列,负责接收引擎发送过来的request请求,然后将请求排队,当引擎需要请求数据的时候,就将请求队列中的数据交给引擎。

查看全部 -

开发环境

cent os 6.0

Python 3.6

Scrapy 1.5

MongoDB 3.6

Pycharm

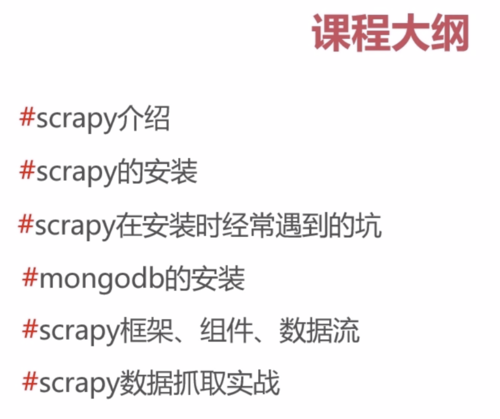

课程大纲

查看全部

查看全部 -

l = len(content) for i in range(l): for j in range(i+1,l): content_s = "".join(content[i].split())+" "+"".join(content[j].split()) douban_item['introduce'] = content_s print(douban_item)

现在豆瓣还追加了导演会导致每个类有两行

我的代码可以让它们合并为一行

查看全部 -

class DoubanSpiderSpider(scrapy.Spider): name = 'douban_spider' allowed_domains = ['movie.douban.com'] start_urls = ['http://movie.douban.com/top250'] # 默认的解析方法 def parse(self, response): movie_list = response.xpath("//div[@class='article']//ol[@class='grid_view']/li") for i_item in movie_list: douban_item = DoubanItem() douban_item['serial_number'] = i_item.xpath(".//div[@class='item']//em/text()").extract_first() douban_item['movie_name'] = i_item.xpath( ".//div[@class='info']/div[@class='hd']/a/span[1]/text()").extract_first() content = i_item.xpath(".//div[@class='info']//div[@class='bd']/p[1]/text()").extract() for i_content in content: content_s = ''.join(i_content.split()) douban_item['introduce'] = content_s douban_item['star'] = i_item.xpath(".//span[@class='rating_num']/text()").extract_first() douban_item['evaluate'] = i_item.xpath(".//div[@class='star']/span[4]/text()").extract_first() douban_item['describe'] = i_item.xpath(".//p[@class='quote']//span/text()").extract_first() yield douban_item # 解析下一页规则,取的后页的xpath next_link = response.xpath("//span[@class='next']/link/@href").extract() if next_link: next_link = next_link[0] yield scrapy.Request('http://movie.douban.com/top250' + next_link, callback=self.parse)查看全部 -

# Crawl responsibly by identifying yourself (and your website) on the user-agent USER_AGENT = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36'

查看全部 -

./configure --prefix='你的python安装目录' --with-ssl

查看全部 -

老师有没有代码

查看全部 -

没有框架我们要做如此多的工作

查看全部 -

下次自学成才自行车行吃现在才现在才x c

查看全部 -

ggggjjjjjjjjjjjjjjjjjj

查看全部 -

添加mongodb的yum源

yum clear all

yum -y install mongodb-org

vim /etc/mongod.conf

修改bindIp

/etc/init.d/mongod restart

开放27017端口

查看全部 -

架构图,数据流查看全部

举报