-

吐槽一下,数据还得自己下。下载的哪个你还不知道。 福利来了,这是网址。Ctrl+c and Ctrl+v 搞定 https://www.kaggle.com/c/santander-customer-satisfaction/data查看全部

-

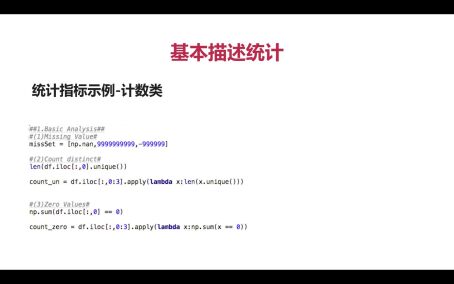

基本描述统计值

特殊值描述值

缺失值

查看全部 -

#(12)Miss Values np.sum(np.isin(df.iloc[:,0], missSet)) df_miss = df.iloc[:,0:3].apply(lambda x:np.sum(np.isin(x, missSet))) 我感觉我也可以在慕课开课了,大家加油查看全部

-

#(11)Frequent Values df.iloc[:,0].value_counts().iloc[0:5,] df.iloc[:,0][~np.isin(df.iloc[:,0], missSet)] df.iloc[:,0][~np.isin(df.iloc[:,0], missSet)].value_counts()[0:5,] json_fre_name = {} json_fre_count = {} def fill_fre_top_5(x): if len(x) <= 5: new_array = np.full(5, np.nan) new_array[0:len(x)] = x return new_array df['ind_var1_0'].value_counts() len(df['imp_sal_var16_ult1'].value_counts()) for i,name in enumerate(df[['ind_var1_0','imp_sal_var16_ult1']].columns): index_name = df[name][~np.isin(df[name], missSet)].value_counts().iloc[0:5,].index.values index_name = fill_fre_top_5(index_name) json_fre_name[name] = index_name values_count = df[name][~np.isin(df[name], missSet)].value_counts().iloc[0:5,].values values_count = fill_fre_top_5(values_count) json_fre_count[name] = values_count df_fre_name = pd.DataFrame(json_fre_name)[df[['ind_var1_0','imp_sal_var16_ult1']].columns].T查看全部

-

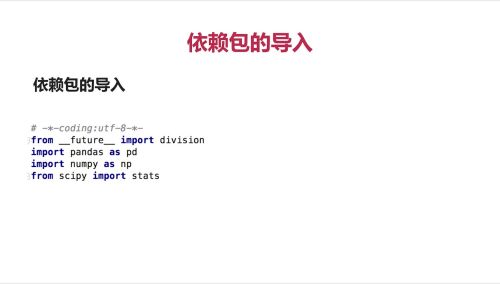

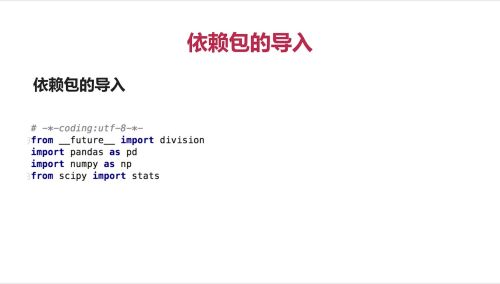

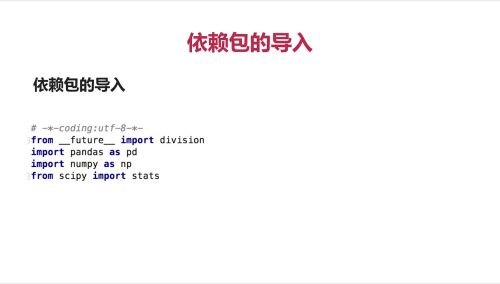

# coding:utf-8 from __future__ import division import numpy as np import pandas as pd from scipy import stats查看全部

-

定义缺失值。np.nan是Numpy缺失的一个表示

计数值,

len来计数

apply函数遍历每一列

df.iloc[指定的行数开头:指定的行数结尾,指定的列数] unique函数看这一个特征有多少个不同的值

找0值

df.iloc[:,0:3] ==0 会返回每一个值是否是0的一个数组True或者False np.sum对数组取和(True当作1,False当作0)算出有多少个True

查看全部 -

统计指标可以自己去构建,以上是常规指标

查看全部 -

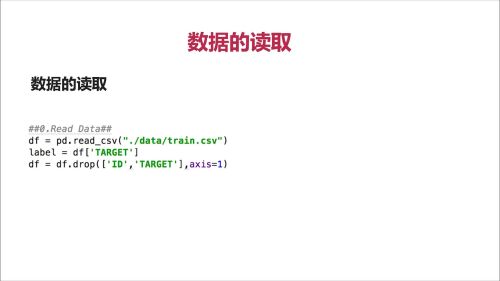

读取下载的数据。把数据集都进来命名df

lable属于预测目标,‘TARGET’就是特征的名字。在df中把因变量TARGET取出来命名为lable

删除掉一些不需要的值。把ID,TARGET这两列去掉重新赋值为df

查看全部 -

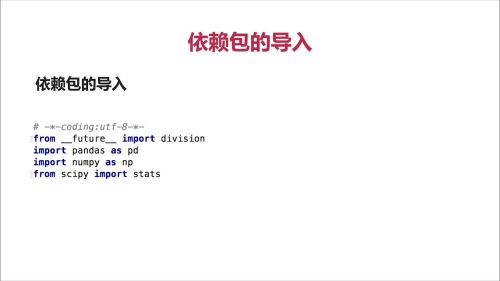

依赖包:Numpy

Pandas

Scipy

查看全部

查看全部 -

依赖包:1、numpy 2、pandas 3、scipy

查看全部

查看全部 -

数据诊断的目的:1、了解特征的分布,缺失和异常等情况 2、统计指标可直接用于数据预处理

查看全部 -

测试

查看全部 -

统计指标介绍

查看全部 -

数据获取与读取1

查看全部 -

数据诊断目的

查看全部

举报

0/150

提交

取消