import urllib.request

print("第一种抓取链接的内容的方法:")

url='http://www.baidu.com'

response1=urllib.request.urlopen(url)

html=response1.read()

print(response1.getcode())#获取http状态码

print(len(html))#返回爬取内容的长度

print(html.decode('utf-8'))#输入百度网页对应的代码

import urllib.request

print("第二种抓取链接的内容的方法:")

url='http://www.baidu.com'

request=urllib.request.Request(url)

request.add_header("User_Agent","Mozilla/5.0")

response2=urllib.request.urlopen(url)

html=response2.read()

print(response2.getcode())#获取http状态码

print(len(html))#返回爬取内容的长度

print(html.decode('utf-8'))#输入百度网页对应的代码

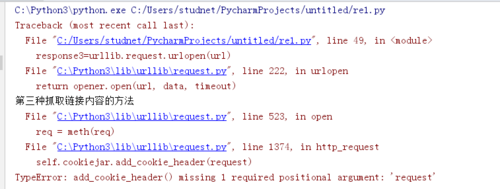

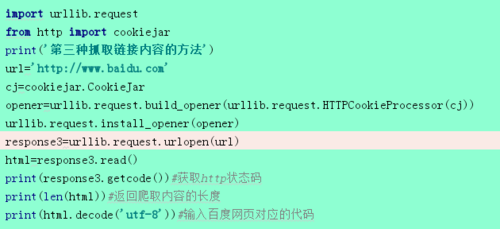

import urllib.request

from http import cookiejar

print('第三种抓取链接内容的方法')

url='http://www.baidu.com'

cj=cookiejar.CookieJar

opener=urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

urllib.request.install_opener(opener)

response3=urllib.request.urlopen(url)

html=response3.read()

print(response3.getcode())#获取http状态码

print(len(html))#返回爬取内容的长度

print(html.decode('utf-8'))#输入百度网页对应的代码