-

hadoop存放文件命令 hadoop fs -put hadoop-env.sh /input<br> hadoop获取文件命令 hadoop fs -get<br> hadoop删除文件命令 hadoop fs -rm <br> hadoop创建目录命令 hadoop fs -mkdir<br> hadoop 格式化操作 : hadoop namenode -formet hadoop查看存储信息 hadoop dfsadmin -report<br>

查看全部 -

hadoop 的组成:

HDFS:分布式文件系统,存储海量的数据

MapReduce:并行处理框架,实现任务分解和调度

查看全部 -

MapReduce容错机制查看全部

-

MapReduce作业执行过程

查看全部 -

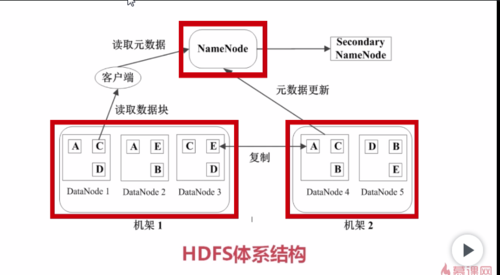

HDFS体系结构

查看全部 -

HDFS的文件被分成块进行存储,HDFS块默认大小是64MB,快是整个文件存储处理的逻辑单元

HDFS中有两类节点NameNode和DataNode

namenode是管理节点,存放文件元数据,元数据包含两个部分

文件与数据快的映射表

数据块与数据节点的映射表

namenode是唯一的管理节点,里面存放大量元数据,客户进行访问请求,首先会到namenode查看元数据,这个文件放在哪些节点上面然后从这些节点拿数据块,然后组装成想要的文件

DateNode是HDFS的工作节点,存放数据块

查看全部 -

dfs.data.dir文件块的存放目录

查看全部 -

首先需要刷新配置文件 resource /etc/profile

hadoop namenode -format指令来格式化namenode

在/bin目录下,执行start-all.sh指令启动集群

hadoop fs -ls / 查看根目录下内容

输入jps进行查看

查看全部 -

需要刷新指令source /etc/profile

然后用hadoop来测试是否安装成功。

查看全部 -

第四个配置文件 /etc/profile,告诉我们系统hadoop将装在哪里

vim /etc/profile

配置hadoop环境变量,hadoop_home变量,然后放入path中

查看全部 -

第三个配置文件 mapred-site.xml,任务调度器该如何访问

vim mapred-site.xml进入

值<value>主机名字加端口号</value>

查看全部

查看全部 -

配置hdfs-site.xml文件

vim hdfs-site.xml,文件系统的数据的存放目录

一个属性

属性的名字是文件系统数据

值是放在/hadoop/data文件目录下

查看全部

查看全部 -

hadoop环境配置:主要在conf文件夹下配置四个文件

第一步:切换到/conf目录下

vim hadoop-env.sh文件

这里的java_home与刚才配置的jdk中java_home一致,通过echo $JAVA_HOME指令来查

vi core-site.xml hadoop中大部分文件直接默认配置,只有这四个文件需要手动配置

第一个属性:属性名字是hadoop.tmp.dir,是hadoop工作目录,工作目录在/hadoop下

第二个属性:属性名字是dfs.name.dir,在dfs中所有的namenode元数据都在/hadoop/name下

第三个属性:属性名字是fs.default.name,文件系统的namenode该如何访问hdfs://主机名:端口号

<property>

<name>hadoop.tmp.dir</name>

查看全部 -

第一步:javac查看是否有jdk,没有下载

第二步:查看看javac是否安装好了,然后配置环境告诉系统发

指令 vi /etc/profile

第三步:配置jdk环境,查找jdk安装路径

第四步:配置具体路径

第五步:刷新配置文件,任何目录都可以输入javac

source /etc/profile

查看全部 -

hive:利用hive不需要编写复杂的hadoop任务程序只需要写sql语句,hive就会将sql语句转化成hadoop任务

Habse:存储结构化数据的分布式数据库,与传统关系型数据库不同,Habse放弃事物特性,追求更高的扩展,与HDFS区别,habse提供数据的·随机读写和实时访问,实现对表数据的读写功能,

zookeeper:动物管理员,意为监控hadoop集群中每个节点状态,管理整个集群配置,维护节点间数据一致性等等

查看全部

举报